Stochastische Analysis

Die stochastische Analysis ist ein Teilgebiet der Mathematik, genauer der Wahrscheinlichkeitstheorie. Sie beschäftigt sich mit der Verallgemeinerung von Begriffsbildungen, Aussagen und Modellen der Analysis auf stochastische Prozesse, also auf Funktionen, deren Werte zufällig sind. Im Zentrum der stochastischen Analysis stehen die Formulierung und die Untersuchung von stochastischen Integralen und, darauf aufbauend, von stochastischen Differentialgleichungen.

Historisch geht das Fachgebiet auf Arbeiten des japanischen Mathematikers Kiyoshi Itō ab 1944 zurück. Der wesentliche Impuls dafür war die mathematische Beschreibung des physikalischen Phänomens der brownschen Bewegung durch Albert Einstein und Norbert Wiener. Dieses Modell, der Wiener-Prozess, bildet mit seinen zahlreichen bemerkenswerten Eigenschaften und Verallgemeinerungen einen Startpunkt der stochastischen Analysis. Anwendungen des Fachgebiets finden sich unter anderem in der Biologie, in der Physik und in den Ingenieurwissenschaften, vor allem aber in der Finanzmathematik. Einen ersten Höhepunkt bildete hier das 1973 veröffentlichte bahnbrechende Black-Scholes-Modell zur Bewertung von Optionen auf eine Aktie, deren Kursentwicklung durch eine stochastische Differentialgleichung beschrieben wird.

Einführung

Besonders elementar und klar treten die Begrifflichkeiten der stochastischen Analysis bei ihrem Hauptanwendungsgebiet, der Finanzmathematik, zu Tage. Dazu werden im Folgenden die Vorgänge beim Handel mit einem Finanzinstrument beschrieben, das der Einfachheit halber Aktie genannt wird und einige idealisierte Annahmen erfüllt. Insbesondere soll es möglich sein, das Finanzinstrument jederzeit in beliebigen Mengen zu kaufen und zu verkaufen.

Vom Kursgewinn beim Aktienhandel zum stochastischen Integral

Der Gewinn (oder Verlust) beim Besitz von Aktienanteilen innerhalb eines

bestimmten Zeitraums hängt auf offensichtliche Weise davon ab, wie viele Anteile

man von der Aktie besitzt und wie sich ihr Preis, der Börsenkurs, in diesem

Zeitraum ändert. Besitzt man beispielsweise

Anteile einer Aktie mit Anfangskurs

und steigt der Kurs, etwa innerhalb eines Tages, auf

,

so beträgt der Kursgewinn gerundet

.

Nach diesem Tag könnten weitere Anteile der Aktie gekauft oder verkauft

werden, sodass man nun

Anteile besitzt, also zum Beispiel

,

wenn man noch eine ganze Aktie hinzukauft. Fällt daraufhin der Aktienkurs bis

zum folgenden Tag auf

,

lässt sich der Gesamtgewinn innerhalb der zwei Tage durch

bestimmen. Es ist somit im betrachteten Zeitraum ein negativer Gewinn, also

ein Verlust eingetreten. Allgemein ist der Gesamtgewinn

nach

Zeitabschnitten die Summe der Teilgewinne jedes

einzelnen Abschnitts:

.

Dabei bezeichnet

die Kursänderung im

-ten

Zeitabschnitt und

gibt an, wie viele Anteile der Aktie der Aktionär in diesem Zeitraum

besitzt.

Die Analysis kommt bei diesen elementaren Überlegungen ins Spiel, wenn nicht

mehr nur eine Folge diskreter Handelszeitpunkte, sondern alle Zeitpunkte

aus einem Zeitintervall

betrachtet werden. Eine Aktie hat zu jedem Zeitpunkt

einen Kurs

der sich im Allgemeinen „ständig ändert“. Auch die gehaltenen Anteile

können in idealisierter Weise als ein sich kontinuierlich ändernder Prozess, der

sogenannte Portfolioprozess,

angesehen werden. Der Gesamtgewinn

während des Zeitintervalls

kann dann allerdings nicht mehr durch die oben dargestellte einfache Summierung

endlich vieler Teilgewinne bestimmt werden. Er ergibt sich stattdessen durch

Integration des Portfolioprozesses gewichtet mit den Änderungen des

Aktienkurses, als Formel

geschrieben.

Eine Grundaufgabe der stochastischen Analysis ist es, solche stochastischen

Integrale für möglichst allgemeine Integranden

und Integratoren

mathematisch zu definieren und ihre Eigenschaften zu untersuchen.

Von einem Modell für den Aktienkurs zu stochastischen Differentialgleichungen

Die Überlegungen, die zu obiger Darstellung des Gewinns als ein

stochastisches Integral führen, sind so allgemein, dass sie sinngemäß für

beliebige zeitlich veränderliche Größen durchgeführt werden können. Im konkreten

Beispiel des Aktienhandels stellt sich daher die Frage, wie ein mathematisches

Modell für die zeitliche Entwicklung des Kurses

aussehen könnte. Reale Kursverläufe scheinen sich „zufällig“ auf und ab zu

bewegen. Aus Sicht der Mathematik ist es also naheliegend, jedes

als eine Zufallsvariable

zu modellieren, also als eine Funktion, die jedem Ergebnis

eines (abstrakten) Zufallsexperiments

den Wert

zuordnet. Der Aktienkurs hängt dann sowohl vom Zeitpunkt

als auch von dem Zufallsergebnis

ab: Er ist ein stochastischer

Prozess.

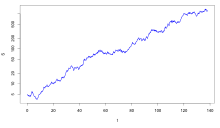

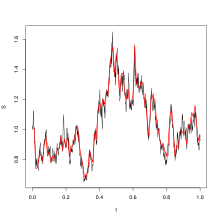

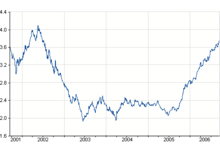

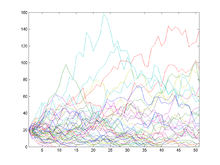

In der Realität erscheinen Aktienkurse zwar zufällig, sind aber nicht völlig

regellos. Über längere Zeiträume „ungestörte“ Kursverläufe weisen häufig als

Grundtendenz

ein exponentielles

Wachstum auf, steigen also beispielsweise von Jahr zu Jahr um einige

Prozent. Das zeigt sich normalerweise noch deutlicher bei Aktienindizes, bei denen

über eine Anzahl von Einzelkursen gemittelt wird, wie etwa – in besonders

ausgeprägter Weise – in der nebenstehenden Grafik des australischen

Aktienindex All

Ordinaries. Ein völlig ungestörtes exponentielles Wachstum von

würde bedeuten, dass die Änderung

in einem kurzen Zeitraum

proportional

zu

und zu

ist:

mit einer Wachstumsrate

.

Bei einem Sparguthaben entspräche dies dem exponentiellen Wachstum durch Zinseszins. Bei Aktien wird

dieses Wachstumsgesetz hingegen in der Realität offenbar durch eine komplizierte

Zufallsbewegung überlagert. Die Statistik und die Wahrscheinlichkeitstheorie

legen es nahe, bei zufälligen Störungen, die sich aus vielen kleinen

Einzeländerungen zusammensetzen, von einer Normalverteilung

als einfachstem Modell auszugehen. Außerdem zeigt sich, dass die Varianz der

Störungen proportional zum betrachteten Zeitraum

ist. Der Wiener-Prozess

besitzt alle diese gewünschten Eigenschaften, eignet sich also als ein Modell

für die zeitliche Entwicklung der Zufallskomponente des Aktienkurses. Insgesamt

führen diese Überlegungen zu folgender Modellgleichung für die Änderung

in einem Zeitintervall

:

.

Dabei bezeichnen

die Änderung des Wiener-Prozesses im betrachteten Zeitraum und

eine Proportionalitätskonstante, die modelliert, wie stark sich die

Zufallskomponente auf die Kursänderung auswirkt, die sogenannte Volatilität.

Das weitere Vorgehen der klassischen Analysis wäre nun, das Zeitintervall

gegen null konvergieren zu lassen und so eine gewöhnliche

Differentialgleichung für die gesuchte Funktion zu gewinnen. Das ist hier

auf diese Weise nicht möglich, denn wie sich herausstellt sind weder die Pfade des

Wiener-Prozesses noch die des gesuchten Aktienkursprozesses differenzierbar,

lassen sich also nicht durch klassische Differentialrechnung untersuchen.

Stattdessen erhält man eine stochastische

Differentialgleichung, die meist in der Form

geschrieben wird. Die dabei verwendeten Differentiale sind ein reiner Notationsbestandteil und es ist Aufgabe der stochastischen Analysis, solchen Gleichungen erst einen mathematischen Sinn zu geben. Das gelingt durch die Beobachtung, dass wegen des Fundamentalsatzes der Analysis Beziehungen zwischen einer differenzierbaren Funktion und ihrer Ableitung auch mithilfe ihres Integrals geschrieben werden können. Entsprechend ist eine stochastische Differentialgleichung nur eine intuitive Schreibweise einer Integralgleichung mit einem stochastischen Integral. Die stochastische Analysis beschäftigt sich unter anderem mit den Fragen, unter welchen Voraussetzungen stochastische Differentialgleichungen eindeutig lösbar sind und welche analytischen und wahrscheinlichkeitstheoretischen Eigenschaften die Lösungen haben. Für einige einfache Typen stochastischer Differentialgleichungen gibt es Methoden, um die Lösungen explizit zu berechnen. So hat zum Beispiel die oben hergeleitete Gleichung für den Aktienkurs als Lösung die sogenannte geometrische brownsche Bewegung. Wie es aber auch schon bei gewöhnlichen Differentialgleichungen der Fall ist, können bei vielen stochastischen Differentialgleichungen die Lösungen nur numerisch berechnet werden.

Geschichte

Die Anfänge: Mathematische Modelle für die brownsche Bewegung

Als brownsche Bewegung wird das physikalische Phänomen bezeichnet, dass kleine Partikel, die in einer Flüssigkeit oder in einem Gas schweben, sich auf eine unregelmäßig und zufällig erscheinende Art „zitternd“ bewegen. Sie ist nach dem Botaniker Robert Brown benannt, der sie 1827 zuerst bei der mikroskopischen Untersuchung von Pollenkörnern in einem Wassertropfen beobachtete und beschrieb. In der Folgezeit zeigten Experimente, dass die physikalische Ursache der brownschen Bewegung in der Wärmebewegung der Flüssigkeitsmoleküle liegt. Diese stoßen ständig gegen die viel größeren Partikel und versetzen sie dadurch selbst in eine unregelmäßige Bewegung.

Eine zu ihrer Zeit wissenschaftlich nur wenig beachtete frühe Anwendung der brownschen Bewegung in der Finanzmathematik untersuchte der französische Mathematiker Louis Bachelier, der im Jahr 1900 mit der Hilfe von Zufallsbewegungen versuchte, die Aktienkurse an der Pariser Börse zu modellieren und damit Preisformeln für Optionsscheine herzuleiten. Er nahm damit zahlreiche Ideen aus dem erst 73 Jahre später vorgestellten berühmten Black-Scholes-Modell vorweg.

Die brownsche Bewegung gelangte wieder in das Licht der wissenschaftlichen Öffentlichkeit, als Albert Einstein 1905, also in seinem annus mirabilis, ein mathematisches Modell für das physikalische Phänomen vorstellte. Er nahm darin an, dass die brownsche Bewegung, in moderner Sprechweise, ein stochastischer Prozess mit stetigen Pfaden und unabhängigen normalverteilten Zuwächsen ist, also grundlegende und aus physikalischer Sicht sinnvolle Bedingungen erfüllt. Andere, physikalisch ebenso notwendige Bedingungen setzte er jedoch nicht voraus, vor allem nicht, dass ein Teilchen in einem festen Zeitraum nur eine endliche Wegstrecke zurücklegen kann, die sogenannte Rektifizierbarkeit der Pfade. Da 1905 die maßtheoretische Fundierung der Wahrscheinlichkeitstheorie durch Émile Borel und Henri Lebesgue gerade erst begonnen hatte, konnte Einstein allerdings nicht beweisen, dass sein Modell als ein mathematisches Objekt tatsächlich existiert.

Eine mathematische Konstruktion von Einsteins Modell gelang erst 1923 dem US-amerikanischen Mathematiker Norbert Wiener. Er verwendete dazu einen 1913 von Percy John Daniell entwickelten Zugang zur Maßtheorie sowie die Theorie der Fourierreihen. Bei der Untersuchung der Eigenschaften dieses, ihm zu Ehren auch Wiener-Prozess genannten, Modells zeigte sich, dass dessen Pfade nicht rektifizierbar sind. So stellte sich im Nachhinein heraus, dass Einstein genau die „richtigen“ Eigenschaften in seinem Modell ausgewählt hatte; mit der zusätzlichen Annahme der Rektifizierbarkeit hätte es mathematisch gar nicht existiert.

Im Jahr 1931 fand der sowjetische Mathematiker Andrei Nikolajewitsch Kolmogorow eine Möglichkeit, stochastische Prozesse mithilfe der Analysis zu untersuchen. Er betrachtete Verallgemeinerungen des Wiener-Prozesses, die sogenannten Markow-Prozesse, und entwickelte eine Theorie zu ihrer Beschreibung. Er zeigte, dass sich diese Prozesse in einen nichtzufälligen Drift-Term und in einen rein stochastischen Anteil zerlegen lassen. Damit stellte Kolmogorow einen Zusammenhang zwischen ihren Wahrscheinlichkeitsverteilungen und bestimmten partiellen Differentialgleichungen, den Kolmogorow-Gleichungen, dar. Er verwendete dabei Methoden der klassischen Analysis; eine Verallgemeinerung von Integral- und Differentialrechnung hin zu einer „stochastischen Analysis“ fand sich bei ihm noch nicht.

Der Ansatz von Itō und die weitere Entwicklung

Am Beginn der stochastischen Analysis steht eine Arbeit des japanischen Mathematikers Kiyoshi Itō (1915–2008) aus dem Jahr 1944 mit dem schlichten Titel Stochastic Integral. Itō, der damit als der Begründer des Fachgebiets gilt, konstruierte darin eine allgemeine stochastische Differentialgleichung zur Untersuchung von Markow-Prozessen. Den dabei auftretenden stochastischen Differentialen gab er einen Sinn durch die Konstruktion eines neuen Integralbegriffs für stochastische Prozesse, des Itō-Integrals. In seinen folgenden Arbeiten stellte er zudem eine Verbindung zu Kolmogorows Ergebnissen her, indem er bewies, dass die Lösungen seiner stochastischen Differentialgleichung die Kolmogorow-Gleichungen erfüllen. Dazu veröffentlichte er 1951 eines der grundlegendsten Ergebnisse der stochastischen Analysis, die Itō-Formel. Diese verallgemeinert die Kettenregel, die Produktregel, die Substitutionsregel und die partielle Integration der klassischen Analysis auf stochastische Differentiale bzw. Integrale von sogenannten Itō-Prozessen.

Itōs Arbeiten stellten damit den Startpunkt einer raschen Entwicklung des Fachgebiets dar, die auch heute noch anhält. Wie sich allerdings im Jahr 2000 herausstellte, hatte der deutsch-französische Mathematiker Wolfgang Döblin bereits 1940 zahlreiche von Itōs Ideen vorweggenommen. Weil Döblin, der für Frankreich im Zweiten Weltkrieg kämpfte, seine Arbeit in einem versiegelten Umschlag an die Pariser Académie des sciences schickte, seine Notizen verbrannte und anschließend Suizid beging, um der Gefangennahme durch die deutsche Wehrmacht zu entgehen, wusste jedoch 60 Jahre lang niemand von Döblins Resultaten.

In der Folgezeit von Itōs Arbeiten lag der Schwerpunkt der mathematischen Forschung auf Verallgemeinerungen seiner Ergebnisse. Joseph L. Doob erweiterte 1953 in seinem einflussreichen Buch über stochastische Prozesse Itōs Integral vom Wiener-Prozess auf Prozesse mit unkorrelierten Zuwächsen. Doob beschäftigte sich zudem mit der Fragestellung, wie sein Zerlegungssatz für diskrete Prozesse auf den zeitkontinuierlichen Fall verallgemeinert werden kann. Dieses Problem wurde 1962 von Paul-André Meyer gelöst. Meyer zeigte, dass eine solche Zerlegung, die Doob-Meyer-Zerlegung, nur unter einer Zusatzbedingung, die er „Klasse (D)“ nannte, möglich ist. Im Jahr 1970 verallgemeinerten Catherine Doléans-Dade und Meyer das Itō-Integral auf sogenannte Semimartingale als Integratoren, also auf stochastische Prozesse, die sich aus einem lokalen Martingal und einem Prozess mit lokal endlicher Variation zusammensetzen. Semimartingale sind in gewisser Weise die allgemeinste Klasse von stochastischen Prozessen, für die sich ein sinnvoller Integralbegriff definieren lässt.

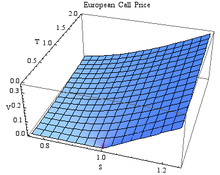

Aus Sicht der Anwendungen der stochastischen Analysis ist das historisch bedeutsamste Ergebnis das nach Vorarbeiten des Wirtschaftswissenschaftlers Paul A. Samuelson und des Mathematikers Henry McKean von Fischer Black, Myron S. Scholes und Robert C. Merton 1973 veröffentlichte Black-Scholes-Modell zur Bewertung von Finanzoptionen. Darin ist der Kurs der zugrunde liegenden Aktie durch die im Einführungsabschnitt dieses Artikels hergeleitete stochastische Differentialgleichung gegeben. Die Itō-Formel, angewendet auf den Preis einer Option als Funktion von Zeit und Aktienkurs, führt dann zusammen mit einer ökonomischen Argumentation mittels eines Hedgegeschäfts auf eine bestimmte partielle Differentialgleichung, die Black-Scholes-Gleichung. Diese lässt sich explizit lösen und ergibt somit Formeln für den Wert von Kauf- und Verkaufsoptionen auf die Aktie. Scholes und Merton erhielten 1997 für ihre Leistungen den Alfred-Nobel-Gedächtnispreis für Wirtschaftswissenschaften („Wirtschaftsnobelpreis“); Black war bereits zwei Jahre zuvor verstorben.

Weitere Entwicklungen der stochastischen Analysis sind beispielsweise die stochastische Differentialgeometrie, die sich mit stochastischen Prozessen auf Mannigfaltigkeiten beschäftigt, und der Malliavin-Kalkül (nach Paul Malliavin), eine Verallgemeinerung der Variationsrechnung auf Funktionale stochastischer Prozesse. Ein anderes aktuelles Forschungsthema sind Theorie und Anwendungen stochastischer partieller Differentialgleichungen.

Grundlegende Begriffe, Aussagen und Methoden

Der Wiener-Prozess und seine analytischen Eigenschaften

Der Wiener-Prozess steht nicht nur historisch als Modell für die brownsche

Bewegung am Anfang der stochastischen Analysis; wegen seiner zahlreichen

mathematisch interessanten Eigenschaften ist er als „Grundtyp“ eines

Zufallsprozesses ein zentrales Untersuchungsobjekt des Fachgebiets. Der

Wiener-Prozess

lässt sich definieren als stochastischer Prozess mit unabhängigen,

tationären

und normalverteilten

Zuwächsen, der fast

sicher stetige

Pfade hat und auf

normiert ist.

Aus der Definition ergeben sich zahlreiche wichtige Eigenschaften, die sich in

natürlicher Weise auf allgemeinere Klassen stochastischer Prozesse

verallgemeinern lassen. So ist der Wiener-Prozess ein typischer Vertreter der Gauß-Prozesse, der Markow-Prozesse

und der Lévy-Prozesse.

Der Wiener-Prozess ist zudem ein sogenanntes Martingal.

Der Zuwachs

hat also, gegeben den aktuellen Wert

,

den bedingten Erwartungswert null. Vereinfacht und anschaulich ausgedrückt: Er

verhält sich wie der Gewinn eines Spielers, der an einem fairen Glücksspiel

teilnimmt, also an einem Spiel, bei dem sich Gewinne und Verluste im Mittel

ausgleichen. Der Martingalbegriff ist ein zentrales Konzept der modernen

Wahrscheinlichkeitstheorie, denn einerseits führen stochastische Modelle häufig

auf ein Martingal oder können in ein solches transformiert werden, andererseits

lassen sich für diese Prozessklasse zahlreiche Sätze beweisen, wie

beispielsweise die Doobsche

Maximalungleichung, das Optional

Sampling Theorem oder die Martingalkonvergenzsätze.

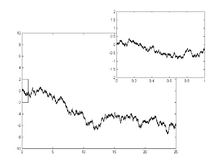

Die Pfade

des Wiener-Prozesses sind fast

sicher an keiner Stelle

differenzierbar,

sind also anschaulich auf allen Zeitskalen so stark „gezackt“, dass nirgends

eine Tangente angelegt werden kann.

Damit entziehen sie sich der Differentialrechnung im klassischen Sinne. Sie sind

allerdings nach Definition stetig, sodass sie problemlos als Integrand eines

klassischen Integrals auftreten können. Die Pfade des Wiener-Prozesses sind

außerdem von unendlicher Variation,

die Gesamtsummen ihrer Änderungen auf einem endlichen Zeitintervall sind also

unbeschränkt. Das hat zur Folge, dass ein Integral mit dem Wiener-Prozess als

Integrator nicht pfadweise als ein klassisches Stieltjesintegral

aufgefasst werden kann; hierzu ist daher ein neuer „stochastischer“

Integralbegriff nötig.

Stochastische Integrale

Im Einführungsabschnitt dieses Artikels wurde dargestellt, wie ein stochastisches Integral als ein Grenzwert von Summen aufgefasst werden kann, bei denen eine Zeitschrittweite gegen null konvergiert. Diese Überlegung lässt sich mathematisch präzisieren und führt auf diese Weise zu einer möglichen Definition eines Integrals mit dem Wiener-Prozess als Integrator, dem Itō-Integral. In modernen Lehrbüchern wird jedoch meist eine etwas abstraktere Konstruktion verwendet, die mehr dem üblichen Vorgehen bei der Definition des Lebesgue-Integrals ähnelt: Zunächst wird ein Integral für elementare Prozesse, also für stückweise konstante Prozesse, als Integranden definiert. Dieser Integralbegriff wird dann mithilfe von Dichtheitsargumenten schrittweise auf allgemeinere Integranden fortgesetzt. In dieser allgemeinen Form sind dann stochastische Integrale

für Semimartingale

als Integratoren und adaptierte

stochastische Prozesse

mit càglàd-Pfaden

möglich. Beide Prozesse können also auch Sprungstellen

besitzen.

Analog zum Begriff der Integralfunktion in der klassischen Analysis betrachtet man auch in der stochastischen Analysis das Integral als Funktion der oberen Integrationsgrenze und erhält so wieder einen stochastischen Prozess

oder in Differentialschreibweise

.

Es lässt sich zeigen, dass

ebenfalls ein Semimartingal ist.

Wenn der Integrator

sogar ein Martingal ist, also zum Beispiel der Wiener-Prozess, und der Integrand

gewissen Beschränktheitsbedingungen genügt, dann ist

ebenfalls ein Martingal. Das stochastische Integral lässt sich in diesem Fall

also als eine zeitkontinuierliche Martingaltransformation

auffassen.

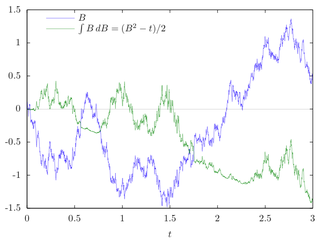

Die Itō-Formel

Für das Itō-Integral und seine Verallgemeinerungen gelten einige der üblichen

Rechenregeln der Analysis nur in modifizierter Form. Das liegt anschaulich

daran, dass wegen der unendlichen Variation des Wiener-Prozesses

bei kleinen Zeitänderungen

nicht nur die zugehörigen Änderungen

berücksichtigt werden müssen, sondern auch deren Quadrate

,

die selbst in der Größenordnung von

liegen. Die sich dadurch ergebenden „neuen“ Rechenregeln werden in der

Itō-Formel zusammengefasst. Bereits in ihrer einfachsten Form wird deutlich, wie

die Kettenregel für den

Wiener-Prozess abgeändert werden muss: Ist

eine zweimal stetig

differenzierbare Funktion, dann gilt für den Prozess

in Differentialschreibweise

.

Im Vergleich zur klassischen Kettenregel erhält man also einen zusätzlichen

Term, der die zweite Ableitung von

enthält.

Die Itō-Formel lässt sich auf vektorwertige Semimartingale verallgemeinern.

Die Zusatzterme dieses Itō-Kalküls machen konkrete Rechnungen mitunter aufwändig und unübersichtlich. Deshalb bietet sich für manche Anwendungsaufgaben ein anderer stochastischer Integralbegriff an, das Stratonowitsch-Integral (nach Ruslan Stratonowitsch). Sein Hauptvorteil gegenüber dem Itō-Integral ist es, dass die Rechenregeln im Wesentlichen denen der klassischen Analysis entsprechen. Insbesondere in physikalischen Problemstellungen ist daher eine Formulierung mit dem Stratonowitsch-Integral häufig natürlicher. Es besitzt jedoch einige wichtige mathematische Eigenschaften des Itō-Integrals nicht; insbesondere ist der Integralprozess kein Martingal. Allerdings lässt sich jede Aussage für Stratonowitsch-Integrale mit Itō-Integralen formulieren und umgekehrt. Beide Begriffe sind also lediglich zwei Darstellungen desselben Sachverhalts.

Stochastische Differentialgleichungen

Eine allgemeine Form einer stochastischen Differentialgleichung ist

mit dem Wiener-Prozess

und gegebenen Funktionen

und

;

der stochastische Prozess

ist gesucht. Diese Differentialnotation ist dabei wie stets nur eine

Kurzschreibweise für stochastische Integrale: Ein Prozess

ist eine Lösung, wenn er die Integralgleichung

erfüllt. Am Anfang der theoretischen Untersuchung dieser Gleichungen steht

die Frage nach Existenz und Eindeutigkeit der Lösungen. Die Bedingungen dafür

ergeben sich in ähnlicher Weise wie in der klassischen Analysis gewöhnlicher

Differentialgleichungen. Analog zum Satz

von Picard-Lindelöf besitzt eine stochastische Differentialgleichung eine

eindeutig bestimmte Lösung ,

die für alle

existiert, wenn die Koeffizientenfunktionen

und

Lipschitz-stetig

und linear

beschränkt sind.

Für einige einfache Typen stochastischer Differentialgleichungen lässt sich die Lösung explizit angeben. Insbesondere lineare Gleichungen lassen sich analog zu den klassischen Methoden – modifiziert in Hinblick auf Itō-Formel – durch einen Exponentialansatz (mit einem stochastischen Exponential) und Variation der Konstanten lösen. Analytische und stochastische Eigenschaften der Lösung lassen sich allerdings häufig bereits aus der Differentialgleichung selbst herleiten. Ein theoretisch wichtiges allgemeines Ergebnis hierzu ist, dass Lösungen stochastischer Differentialgleichungen stets Markow-Prozesse sind.

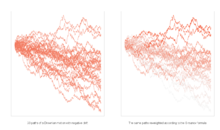

Weiterhin besteht die Möglichkeit, Gleichungen numerisch zu

lösen und damit gesuchte Größen durch eine

Monte-Carlo-Simulation

zu bestimmen. Das einfachste und praktisch wichtigste numerische Verfahren zur

Lösung stochastischer Differentialgleichungen, das Euler-Maruyama-Verfahren,

ist eine direkte Verallgemeinerung des expliziten

Euler-Verfahrens. Dabei werden wie bei der Herleitung der Gleichung kurze

Zeitschritte

betrachtet und das Differential des Wiener-Prozesses durch den Zuwachs

,

also durch eine normalverteilte

Zufallsvariable mit Erwartungswert null und Varianz

,

ersetzt. Wie in der Numerik gewöhnlicher Differentialgleichungen existieren

zahlreiche Weiterentwicklungen des Euler-Maruyama-Verfahrens, die eine höhere Konvergenzordnung

aufweisen, also bei gegebener Schrittweite genauere Näherungen der Lösung

liefern. Ein einfaches Beispiel ist das Milstein-Verfahren.

Im Gegensatz zu dem Fall gewöhnlicher Differentialgleichungen ist die Bedeutung

von Verfahren mit hoher Konvergenzordnung für die meisten praktischen

Anwendungen eher gering. Das liegt zum einen daran, dass solche Verfahren

numerisch sehr aufwändig und damit rechenintensiv sind. Andererseits erfordern

die meisten Anwendungen die schnelle Berechnung sehr vieler Einzelpfade einer

Simulation; die Genauigkeit, mit der ein einzelner Pfad berechnet wird, spielt

dann keine wesentliche Rolle, weil das Endergebnis durch den Fehler der

Monte-Carlo-Simulation dominiert wird.

Anwendungen

Finanzmathematik

Die Anwendung von wahrscheinlichkeitstheoretischen Methoden auf Probleme der Finanzmathematik führte in den letzten Jahrzehnten zu einem fruchtbaren Zusammenspiel von Mathematik und Wirtschaftswissenschaften. Modelle, die zeitliche Entwicklungen ökonomischer Größen zu diskreten Zeitpunkten beschreiben, wie beispielsweise das bekannte Binomialmodell von Cox, Ross und Rubinstein, lassen sich bereits mit elementarer Wahrscheinlichkeitsrechnung aufstellen und untersuchen. Für Fragestellungen mit einem kontinuierlich variierenden Zeitparameter werden jedoch Begriffe und Sätze der stochastischen Analysis benötigt. Die Entwicklung finanzmathematischer Größen wie Aktienkurse, Preise von Derivaten, Wechselkurse oder Zinssätzen wird durch zeitstetige stochastische Prozesse modelliert, deren Änderungen durch geeignete stochastische Differentialgleichungen gegeben sind.

Bewertung von Derivaten

Von einer mathematischen Beschreibung eines Aktienkurses könnte man vielleicht zuerst „naiv“ erwarten, dass ihre Hauptaufgabe die Prognose der weiteren Kursentwicklung sei. Das ist bei der Modellierung durch eine stochastische Differentialgleichung jedoch nicht der Fall, denn dabei geht man wie gesehen davon aus, dass die Kursänderungen zufällig sind, und beschreibt „nur“ diese Zufälligkeit aller möglichen Entwicklungen wahrscheinlichkeitstheoretisch. Eine korrekt gestellte und zentrale Frage ist es hingegen, wie in einem solchen Zufallsmodell der Preis eines Derivats, beispielsweise einer Kaufoption auf eine Aktie, berechnet werden kann.

Ein Derivat ist allgemein ein Finanzinstrument, das eine in der Zukunft liegende Auszahlung ergibt. Die Höhe dieser Auszahlung hängt dabei von einer anderen ökonomischen Größe, wie beispielsweise einem Aktienkurs, ab. Da sich diese bis zum Auszahlungszeitpunkt zufällig ändert, ist auch die Auszahlung des Derivats zufällig. Die wesentliche Frage ist dabei, wie der Preis für ein solches Derivat ermittelt werden kann. Eine naheliegende, aber falsche Idee ist es, dazu alle möglichen Auszahlungen mit ihren jeweiligen Wahrscheinlichkeiten zu mitteln, also den Erwartungswert der Auszahlung zu bilden. Ökonomische Überlegungen zeigen aber beispielsweise die zunächst paradox erscheinende Tatsache, dass der Preis einer Kaufoption auf eine Aktie gar nicht davon abhängt, mit welcher Wahrscheinlichkeit die Aktie steigt oder fällt.

Korrekte Herangehensweisen zur Bewertung von Derivaten sind hingegen das Hedging und die risikoneutrale Bewertung. Die Grundidee des Hedgings ist folgende: Wenn es eine selbstfinanzierende Handelsstrategie gibt, die das Derivat nicht verwendet, aber in allen Fällen die gleiche Auszahlung liefert wie das Derivat, dann muss der Preis des Derivats der gleiche sein wie der Preis der Handelsstrategie. Die risikoneutrale Bewertung beruht hingegen auf dem Prinzip der sogenannten Arbitragefreiheit, vereinfacht gesagt: Das Derivat hat genau dann den richtigen Preis, wenn man beim Handel mit dem Derivat und den übrigen Finanzinstrumenten keinen risikolosen Gewinn erzielen kann. Wäre es zum Beispiel möglich, durch den Kauf des Derivats stets einen positiven Gewinn zu erzielen, dann wäre sein Preis zu niedrig. In der Realität würde der Preis des Derivats steigen, bis ein Marktgleichgewicht eintritt.

Diese ökonomischen Überlegungen lassen sich alle mathematisch formalisieren, wozu im zeitkontinuierlichen Fall die Methoden der stochastischen Analysis benötigt werden. Unter gewissen technischen Voraussetzungen an das Marktmodell lässt sich beweisen, dass sowohl der Ansatz über das Hedging als auch die Ermittlung des arbitragefreien Preises eindeutig durchführbar sind und die gleichen Ergebnisse liefern. Ein recht allgemeiner mathematischer Zugang stellt den arbitragefreien Preis eines Derivats zu einem bestimmten Zeitpunkt durch einen bedingten Erwartungswert dar. Wie oben bemerkt, kann dazu aber nicht das reale Wahrscheinlichkeitsmaß, das die Entwicklung des Aktienkurses bestimmt, verwendet werden. Stattdessen wird ein Maßwechsel auf das risikoneutrale Wahrscheinlichkeitsmaß betrachtet. Unter diesem auch äquivalentes Martingalmaß genannten Maß ist der diskontierte Aktienkurs ein Martingal, verhält sich also vereinfacht gesagt wie der Gewinn eines Spielers, der an einem fairen Glücksspiel teilnimmt. Die Umrechnungsformeln für die Lösungen der stochastischen Differentialgleichungen werden dabei durch den Satz von Girsanow bereitgestellt. Das Problem, den arbitragefreien Preis als bedingten Erwartungswert abhängig von der Zeit und dem Anfangswert zu bestimmen, kann zudem mithilfe des Satzes von Feynman-Kac auf das Lösen einer (nicht stochastischen) partiellen Differentialgleichung zurückgeführt werden.

Zinsmodelle

Bei allen ökonomischen Betrachtungen, die Preise zu verschiedenen Zeitpunkten enthalten, muss der Zeitwert des Geldes berücksichtigt werden, dessen Hauptursachen die Verzinsung und die Inflation sind. Im einfachsten Fall, so auch im Black-Scholes-Modell, wird dazu ein festverzinsliches Wertpapier mit einem risikolosen zeitlich konstanten Zinssatz betrachtet. Alle zukünftigen Auszahlungen, wie etwa bei einem Derivat auf eine Aktie, müssen dann nur noch gemäß der stetigen Verzinsung durch einen Exponentialfaktor dividiert werden, um ihren momentanen Wert zu erhalten.

In der Realität fluktuieren Zinsraten jedoch ähnlich wie Aktienkurse, was

nahelegt, sie ebenfalls im Sinne der stochastischen Analysis als stochastische

Prozesse zu modellieren. Mit den sogenannten Short-Rate-Modellen

existieren zahlreiche Ansätze, um die zeitliche Entwicklung eines Momentanzinses

(„Short-Rate“)

durch stochastische Differentialgleichungen zu beschreiben. Mit dem so

modellierten Momentanzins lassen sich dann die Preise verzinslicher Wertpapiere,

wie Nullkuponanleihen

oder Floater, darstellen. Durch

risikoneutrale Bewertung erhält man zudem wie im Aktienfall Preisformeln für Zinsderivate wie Caps, Swaps und Swaptions.

Beispiele für einfache Modelle sind das Ho-Lee-Modell,

das

als einen skalierten Wiener-Prozess annimmt, und das Dothan-Modell,

das dafür eine geometrische brownsche Bewegung verwendet. Solche Ansätze führen

zwar zu mathematisch einfachen Herleitungen, beschreiben aber aus verschiedenen

Gründen die Realität nur schlecht. So lässt sich etwa für das Dothan-Modell

mathematisch zeigen, dass es damit möglich wäre, in einem endlichen Zeitraum

unendlich viel Geld zu verdienen.

Reale Zinsraten zeigen überwiegend ein dem sogenannten Mean-Reversion-Effekt

entsprechendes Verhalten, kehren also trotz ihrer scheinbar zufälligen

Schwankungen immer wieder zu einem mittleren Wert zurück. Zwei wichtige

Grundtypen von Differentialgleichungsmodellen, die diesen Effekt nachbilden,

sind das Vasicek-Modell

sowie das verbreitete Cox-Ingersoll-Ross-Modell.

Einen anderen Zugang zur Modellierung von Zinsen verwendet die Gruppe der HJM-Modelle, die nicht den

Momentanzins, sondern den

Terminzins („Forward-Rate“)

beschreiben.

Physik, Chemie und Ingenieurwissenschaften

Die Bewegung physikalischer Körper wird durch die newtonschen Gesetze beschrieben: Eine Kraft, die auf einen Körper wirkt, bewirkt bei konstanter Masse eine Änderung seiner Geschwindigkeit. Hängt die Kraft in gegebener Weise vom Ort und von der Geschwindigkeit des Körpers ab, ergibt sich eine Gleichung, die die Beschleunigung, die Geschwindigkeit und den Ort des Körpers zueinander in Beziehung setzt. Da die Beschleunigung die Ableitung der Geschwindigkeit und die Geschwindigkeit die Ableitung des Ortes ist, handelt es sich dabei um eine gewöhnliche Differentialgleichung. Hat die Kraft zusätzlich eine Zufallskomponente, wird daraus eine stochastische Differentialgleichung.

Die physikalische Beschreibung von Partikeln, die der brownschen Bewegung unterliegen, lässt sich stark verfeinern und verallgemeinern. So ergibt sich beispielsweise für Partikel, auf die zusätzlich eine zur Geschwindigkeit proportionale Reibungskraft (Gesetz von Stokes) und gegebenenfalls noch eine konstante Kraft wirken, dass die Geschwindigkeit eine Lösung der Ornstein-Uhlenbeck-Gleichung ist, einer stochastischen Differentialgleichung, die explizit gelöst werden kann. Die Physik verwendet für diesen Gleichungstyp üblicherweise eine andere Darstellungsweise, die auf Paul Langevin zurückgeht und als Langevin-Gleichung bezeichnet wird. Dabei wird die Differentialgleichung mit einem sogenannten weißen Rauschen notiert, das als formale Ableitung des nichtdifferenzierbaren Wiener-Prozesses interpretiert werden kann. Solche Bewegungsgleichungen können noch weiter verallgemeinert werden, zum Beispiel auf Schwingungen mit zufälligen Störungen. Hier ist die Beschleunigung abhängig von der Auslenkung, von der Geschwindigkeit und zusätzlich von einer zufälligen normalverteilten Kraft, deren Standardabweichung ebenfalls von Ort und Geschwindigkeit abhängen kann. Zusammen mit der Tatsache, dass die Geschwindigkeit die Ableitung des Ortes ist, ergibt sich somit ein System aus zwei stochastischen Differentialgleichungen.

Im Allgemeinen ist man bei physikalischen Fragestellungen nicht so sehr an den Bewegungspfaden einzelner Partikel interessiert als vielmehr am gemittelten Verhalten sehr vieler Partikel, das sich als Diffusion bemerkbar macht. Die zeitliche Entwicklung der zugehörigen Dichtefunktion erfüllt eine (nicht stochastische) partielle Differentialgleichung, die nach Adriaan Daniël Fokker und Max Planck benannte Fokker-Planck-Gleichung. Weitere Verallgemeinerungen der Diffusion ergeben Anwendungen in der theoretischen Chemie: Berücksichtigt man zusätzlich zu den physikalischen Zufallsbewegungen von Teilchen auch die Möglichkeit chemischer Reaktionen zwischen ihnen, ergeben sich anstelle der linearen Fokker-Planck-Gleichungen nichtlineare Reaktionsdiffusionsgleichungen. Mit ihrer Hilfe lassen sich zahlreiche interessante Phänomene der Musterbildung, wie oszillierende Reaktionen, chemische Wellen oder Morphogenese, studieren.

Viele Anwendungen in den Ingenieurwissenschaften und in der Technik lassen sich auf die Problemstellung des stochastischen Filterns zurückführen. Dabei wird ein dynamisches System, dessen zeitliche Entwicklung durch eine Differentialgleichung beschrieben wird, beobachtet. Im Allgemeinen ist es dabei nicht möglich, alle Variablen des Systems direkt zu beobachten; außerdem unterliegen sowohl die Systemgleichung als auch die Beobachtungsgleichung zufälligen Störungen: Es ergibt sich ein System stochastischer Differentialgleichungen und es besteht die Aufgabe, aus den Beobachtungen auf die Entwicklung des Systems zu schließen. Im zeitdiskreten Fall, also wenn nur endlich viele Beobachtungen zu bestimmten Zeitpunkten vorliegen, existiert hierfür eine wichtige Schätzmethode, das Kalman-Filter. Dieses lässt sich im zeitkontinuierlichen Fall zum sogenannten Kalman-Bucy-Filter verallgemeinern. Noch einen Schritt weiter geht die stochastische Kontrolltheorie: Hier hängt die Differentialgleichung, die das System beschreibt, zusätzlich von einer, gegebenenfalls bis auf Nebenbedingungen, frei wählbaren Steuerungsfunktion ab. Gesucht ist eine optimale Steuerung des Systems. Zentral für die Theorie solcher Aufgaben ist die Hamilton-Jacobi-Bellman-Gleichung, eine partielle Differentialgleichung, die sich aus dem Optimalitätsprinzip von Bellman durch Übergang zu kontinuierlicher Zeit ergibt. Mit der Itō-Formel lässt sich die Hamilton-Jacobi-Bellman-Gleichung auf stochastische Differentialgleichungen übertragen.

Biologie

Zahlreiche Modelle in der Biologie verwenden Begriffe und Methoden der stochastischen Analysis. Einfache diskrete stochastische Modelle für das Wachstum einer Population sind die sogenannten Verzweigungsprozesse wie der Galton-Watson-Prozess: Jedes Individuum bekommt unabhängig von den anderen in einer Generation eine zufällige Anzahl von Nachkommen und stirbt anschließend. William Feller stellte 1951 mit dem Branching-Diffusion-Modell eine zeitkontinuierliche Version eines Verzweigungsprozesses vor, in der die Größe der Population durch eine stochastische Differentialgleichung gegeben ist. Mit wahrscheinlichkeitstheoretischen Standardmethoden lassen sich Formeln für das exponentielle Wachstum des Erwartungswerts der Populationsgröße und für die Aussterbewahrscheinlichkeit herleiten.

Ein anderer Typ von stochastischen Modellen für die Entwicklung von Populationen sind Geburts- und Todesprozesse, bei denen sich nach zufälligen Zeitintervallen die Größe der Population um jeweils ein Individuum vergrößert oder verringert. Im einfachsten Fall sind die Zeitintervalle exponentialverteilt mit konstanten Raten. Die Populationsgröße ist nun ein unstetiger Sprungprozess, der eine stochastische Integralgleichung mit einem lokalen Martingal als Zufallskomponente erfüllt. Komplizierter und interessanter als der Fall des konstanten, „ungebremsten“ Wachstums ist dabei das sogenannte langsame Wachstum, bei dem die Wachstumsrate für wachsende Populationsgrößen gegen null konvergiert. Hier lassen sich Fälle von aussterbenden, linear wachsenden und schneller als linear wachsenden Populationen unterscheiden. Es ergeben sich wieder Formeln für die Aussterbewahrscheinlichkeit sowie für die Erwartungswerte verschiedener Stoppzeiten – beispielsweise für die Zeit, bis die Population eine bestimmte Maximalgröße erreicht.

Ein zeitkontinuierliches Modell für die Gendrift, also für die zeitliche Entwicklung der Häufigkeiten bestimmter Gene oder Allele in einer Population, ist die Fisher-Wright-Diffusion. Im einfachsten Fall werden dabei zwei Typen von Individuen in einer Population betrachtet, deren Anteile zufällig fluktuieren und mit gegebenen Raten ineinander mutieren. Aus der zugehörigen stochastischen Differentialgleichung lassen sich Bedingungen herleiten, ob sich mit der Zeit eine stationäre Verteilung einstellt oder ob ein Typ ausstirbt. Im zweiten Fall ergibt sich eine explizite Formel für die erwartete Zeit bis zum Aussterben. Ein anderes Modell für die Gendrift ist das Moran-Modell. Hier ist die Grundidee, dass sich die Population entwickelt, indem jeweils ein zufällig ausgewähltes Individuum stirbt und ein anderes sich fortpflanzt. Beim Übergang zu kontinuierlicher Zeit ergibt sich wieder eine stochastische Integralgleichung. Verfeinerungen des Modells berücksichtigen auch Mutationen und Selektionsvorteile.

Es existieren zahlreiche biologische Modelle, die speziell die Entstehung und Entwicklung von Krebs beschreiben. Ein einfacher Zugang sind Onkogen-Modelle, die das Moran-Modell auf mutierte und nichtmutierte Zellen anwenden. Verallgemeinerungen hiervon beruhen auf der Knudsonhypothese, nach der die Ursache der Krebsentstehung unabhängige Mehrfachmutationen sind. So verwendet das Two-Hit-Modell Zellen mit keiner, einer oder zwei Mutationen. Mathematisch lässt sich die Entwicklung von mehreren Zellarten als Geburts- und Todesprozess in mehreren Dimensionen auffassen. Ein weiterer Ansatz ist das kinetische Modell von Garay und Lefever aus dem Jahr 1978, das auf eine gewöhnliche Differentialgleichung für die Konzentration maligner Zellen in einem Organismus führt. Dazu existieren verschiedene Ansätze, die zusätzliche zufällige Fluktuationen der Konzentration mitberücksichtigen und somit in bekannter Weise auf unterschiedliche stochastische Differentialgleichungen führen.

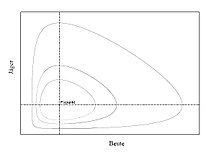

Die Biologie beschäftigt sich auch mit Modellen für die zeitliche Entwicklung mehrerer Populationen, die sich gegenseitig beeinflussen. Ein bekannter einfacher Ansatz dazu, das Lotka-Volterra-Modell, betrachtet eine „Räuber“- und eine „Beute“-Population. Die beiden Populationen erfüllen ein System aus zwei gewöhnlichen Differentialgleichungen, bei denen die Wachstumsraten von der jeweils anderen Population abhängen. Ein Nachteil dieser einfachen Modellierung ist es, dass dabei kein Aussterben einer Population dargestellt werden kann, denn wie sich mathematisch beweisen lässt, sind die Lösungen der Lotka-Volterra-Gleichungen periodisch und für alle Zeiten positiv. Das ändert sich, wenn man zusätzlich geeignete stochastische Komponenten einführt. Für das dabei erhaltene stochastische Differentialgleichungssystem lässt sich nun die erwartete Zeit bis zum Aussterben der Beutepopulation bestimmen.

Literatur

- Thomas Deck: Der Itô-Kalkül: Einführung und Anwendungen. Springer, Berlin u. a. 2006, ISBN 3-540-25392-0.

- Wolfgang Hackenbroch, Anton Thalmaier: Stochastische Analysis – Eine Einführung in die Theorie der stetigen Semimartingale. Springer Fachmedien, Wiesbaden 1994, ISBN 978-3-519-02229-9.

- Fima C. Klebaner: Introduction to Stochastic Calculus with Applications. 3. Auflage. Imperial College Press, London 2012, ISBN 978-1-84816-831-2.

- Jean-François Le Gall: Brownian Motion, Martingales, and Stochastic Calculus. Springer, Berlin/Heidelberg 2013, ISBN 978-3-319-31088-6.

- Albrecht Irle: Finanzmathematik: Die Bewertung von Derivaten. 3. Auflage. Springer Spektrum, Wiesbaden 2012, ISBN 978-3-8348-1574-3.

- Stefan Reitz: Mathematik in der modernen Finanzwelt: Derivate, Portfoliomodelle und Ratingverfahren. Vieweg+Teubner, Wiesbaden 2011, ISBN 978-3-8348-0943-8.

- Michael Hoffmann: Stochastische Integration: Eine Einführung in die Finanzmathematik. 1. Auflage. Springer Spektrum, Wiesbaden 2016, ISBN 978-3-658-14131-8.

© biancahoegel.de

Datum der letzten Änderung: Jena, den: 28.01. 2026