Charakteristische Funktion (Stochastik)

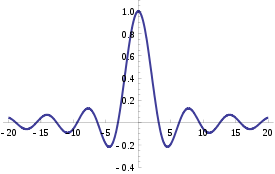

Als charakteristische Funktion bezeichnet man in der Wahrscheinlichkeitstheorie eine spezielle komplexwertige Funktion, die einem endlichen Maß oder spezieller einem Wahrscheinlichkeitsmaß auf den reellen Zahlen beziehungsweise der Verteilung einer Zufallsvariable zugeordnet wird. Dabei wird das endliche Maß eindeutig durch seine charakteristische Funktion bestimmt und umgekehrt, die Zuordnung ist also bijektiv.

Wesentlicher Nutzen von charakteristischen Funktionen liegt darin, dass viele schwerer greifbaren Eigenschaften des endlichen Maßes sich als Eigenschaft der charakteristischen Funktion wiederfinden und dort als Eigenschaft einer Funktion leichter zugänglich sind. So reduziert sich beispielsweise die Faltung von Wahrscheinlichkeitsmaßen auf die Multiplikation der entsprechenden charakteristischen Funktionen.

Definition

Gegeben sei ein endliches

Maß

auf

.

Dann heißt die komplexwertige Funktion

definiert durch

die charakteristische Funktion von .

Ist

ein Wahrscheinlichkeitsmaß,

so folgt die Definition analog. Ist speziell eine Zufallsvariable

mit Verteilung

gegeben, so ist die charakteristische Funktion gegeben durch

.

Damit ergeben sich als wichtige Sonderfälle:

- Besitzt

eine Wahrscheinlichkeitsdichtefunktion (bezüglich des Riemann-Integrals)

, so ist die charakteristische Funktion gegeben als

.

- Besitzt

eine Wahrscheinlichkeitsfunktion

, so ist die charakteristische Funktion gegeben als

.

Elementare Beispiele

Ist

Poisson-verteilt,

so besitzt

die Wahrscheinlichkeitsfunktion

.

Mit der oben aufgeführten Darstellung für die charakteristische Funktion mittels Wahrscheinlichkeitsfunktionen ergibt sich dann

Ist

exponentialverteilt

zum Parameter

,

so besitzt

die Wahrscheinlichkeitsdichtefunktion

Damit ergibt sich

Weitere Beispiele für Charakteristische Funktionen sind weiter unten im Artikel tabelliert oder befinden sich direkt im Artikel über die entsprechenden Wahrscheinlichkeitsverteilungen.

Eigenschaften als Funktion

Existenz

Die charakteristische Funktion existiert für beliebige endliche Maße und somit auch Wahrscheinlichkeitsmaße bzw. Verteilungen von Zufallsvariablen, da wegen

das Integral stets existiert.

Beschränktheit

Jede charakteristische Funktion ist immer beschränkt, es gilt

.

Symmetrie

Die charakteristische Funktion

ist genau dann reellwertig,

wenn die Zufallsvariable

symmetrisch

ist.

Des Weiteren ist

stets hermitesch, das heißt es gilt

.

Gleichmäßige Stetigkeit

ist eine gleichmäßig stetige Funktion.

Charakterisierung

Interessant ist insbesondere, wann eine Funktion

die charakteristische Funktion eines Wahrscheinlichkeitsmaßes ist. Eine

hinreichende Bedingung liefert der Satz von Pólya (nach George Pólya): Ist

eine Funktion

und gilt außerdem ,

so ist sie die charakteristische Funktion eines Wahrscheinlichkeitsmaßes.

Eine notwendige und hinreichende Bedingung liefert der Satz von Bochner (nach Salomon Bochner):

Eine stetige Funktion

ist genau dann die charakteristische Funktion eines Wahrscheinlichkeitsmaßes,

wenn

eine positiv

semidefinite Funktion ist und

gilt.

Weitere Eigenschaften

Lineare Transformation

für alle reellen

Umkehrbarkeit

Ist

integrierbar,

dann lässt sich die Wahrscheinlichkeitsdichte von

rekonstruieren als

Momenterzeugung

für alle natürlichen

, falls

.

Insbesondere ergeben sich die Spezialfälle

Wenn für eine natürliche Zahl

der Erwartungswert

endlich ist, dann ist

-mal

stetig differenzierbar und in eine Taylor-Reihe

um

entwickelbar:

Ein wichtiger Spezialfall ist die Entwicklung einer Zufallsvariablen

mit

und

:

Faltungsformel für Dichten

Bei unabhängigen

Zufallsvariablen

und

gilt für die charakteristische Funktion der Summe

denn wegen der Unabhängigkeit gilt

Charakteristische Funktion von zufälligen Summen

Sind

unabhängig

identisch verteilte Zufallsvariablen und

eine

-wertige

Zufallsvariable, die von allen

unabhängig ist, so lässt sich die charakteristische Funktion der

Zufallsvariable

als Verkettung der

wahrscheinlichkeitserzeugenden

Funktion

von

und der charakteristischen Funktion von

darstellen:

.

Eindeutigkeitssatz

Es gilt der folgende Eindeutigkeitssatz: Wenn ,

Zufallsvariablen sind und

für alle

gilt, dann ist

,

d.h.

und

haben die gleiche Verteilungsfunktion. Folglich kann damit die Faltung einiger

Verteilungen leicht bestimmt werden.

Aus dem Eindeutigkeitssatz lässt sich der Stetigkeitssatz

von Lévy folgern: Wenn

eine Folge von Zufallsvariablen ist, dann gilt

(Konvergenz

in Verteilung) genau dann, wenn

für alle

gilt. Diese Eigenschaft kann bei zentralen

Grenzwertsätzen ausgenutzt werden.

Beispiele

| Verteilung | Charakteristische Funktion |

|---|---|

| Diskrete Verteilungen | |

| Binomialverteilung

|

|

| Poisson-Verteilung

|

|

| Negative

Binomialverteilung |

|

| Absolutstetige Verteilungen | |

Allgemeinere Definitionen

Definition für mehrdimensionale Zufallsvariablen

Die charakteristische Funktion lässt sich auf -dimensionale

reelle Zufallsvektoren

wie folgt erweitern:

,

wobei

das Standardskalarprodukt

bezeichnet.

Für zufällige Maße

Die charakteristische Funktion lässt sich auch für zufällige Maße

definieren. Sie ist dann jedoch ein Funktional,

ihre Argumente sind also Funktionen. Ist

ein zufälliges Maß, so ist die charakteristische Funktion gegeben als

für alle beschränkten, messbaren reellwertigen Funktionen

mit kompaktem Träger.

Das zufällige Maß ist durch die Werte der charakteristischen Funktion an allen

positiven

stetigen Funktionen mit kompaktem Träger eindeutig bestimmt.

Beziehung zu anderen erzeugenden Funktionen

Außer den charakteristischen Funktionen spielen noch die wahrscheinlichkeitserzeugenden Funktionen und die momenterzeugenden Funktionen eine wichtige Rolle in der Wahrscheinlichkeitstheorie.

Die wahrscheinlichkeitserzeugende Funktion einer -wertigen

Zufallsvariable

ist definiert als

.

Demnach gilt der Zusammenhang

.

Die momenterzeugende Funktion einer Zufallsvariable ist definiert als .

Demnach gilt der Zusammenhang

,

wenn die momenterzeugende Funktion existiert. Im Gegensatz zur

charakteristischen Funktion ist dies nicht immer der Fall.

Außerdem gibt es noch die kumulantenerzeugende Funktion als Logarithmus der momenterzeugenden Funktion. Aus ihr wird der Begriff der Kumulante abgeleitet.

Siehe auch

© biancahoegel.de

Datum der letzten Änderung: Jena, den: 09.01. 2021