Varianz (Stochastik)

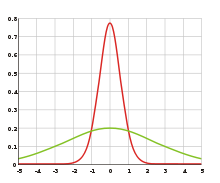

Die rote Kurve hat eine geringere Varianz (entsprechend der Breite) als die grüne.

Die Quadratwurzel der Varianz, die Standardabweichung, kann bei der Normalverteilung an den Wendepunkten ersehen werden.

In der Stochastik ist die Varianz eine wichtige Kenngröße der Wahrscheinlichkeitsverteilung einer reellen Zufallsvariablen. Sie beschreibt die erwartete quadratische Abweichung der Zufallsvariablen von ihrem Erwartungswert. Damit stellt die Varianz das zweite zentrale Moment der Zufallsvariablen dar. Die Quadratwurzel der Varianz wird Standardabweichung der Zufallsvariablen genannt.

Die Varianz ist translationsinvariant und eine homogene Funktion zweiten Grades. Die Varianz einer Summe unkorrelierter Zufallsvariablen ist gleich der Summe ihrer Varianzen. Ein wichtiges Hilfsmittel zur Berechnung der Varianz stellt der Verschiebungssatz dar. Die Varianz kann mit einem Varianzschätzer, etwa ihrer empirischen Entsprechung, der Stichprobenvarianz, geschätzt werden.

Definition

Es sei

eine reelle Zufallsvariable,

die integrierbar ist, das heißt, es gilt

.

Dann existiert ihr Erwartungswert

,

und man definiert die Varianz von

wie folgt:

Ist

quadratisch integrierbar, gilt also

,

so ist die Varianz endlich. Die Varianz wird auch als

,

oder einfach als

notiert.

Berechnung bei diskreten Zufallsvariablen

Eine reelle Zufallsvariable mit einem endlichen

oder abzählbar

unendlichen Wertebereich

wird diskret

genannt. Ihre Varianz berechnet sich dann als

Hierbei ist

die Wahrscheinlichkeit, dass

den Wert

annimmt, und

der Erwartungswert von .

Die Summen erstrecken sich jeweils über alle Werte, die die Zufallsvariable

annehmen kann.

Berechnung bei stetigen Zufallsvariablen

Wenn eine Zufallsvariable

eine Wahrscheinlichkeitsdichtefunktion

hat, gilt

wobei

Rechenregeln

Verschiebungssatz

Varianzen lassen sich oft einfacher mit Hilfe des Verschiebungssatzes

berechnen, da hierzu außer dem Erwartungswert von

nur noch der Erwartungswert von

bestimmt werden muss.

Diskret bedeutet das:

Am Computer ist diese Art der Berechnung aber zu vermeiden, da es bei der Verwendung von Fließkommazahlen leicht zu katastrophaler Auslöschung kommen kann.

Lineare Transformation

Für reelle Zahlen

und

gilt

Dies kann mittels des Verschiebungssatzes hergeleitet werden:

Insbesondere für

und

folgt

Varianz von Summen von Zufallsvariablen

Für die Varianz einer beliebigen Summe von Zufallsvariablen

gilt allgemein

Hierin bezeichnet

die Kovarianz

der Zufallsvariablen

und

und es wurde verwendet, dass

gilt. Speziell für zwei Zufallsvariablen

und

ergibt sich beispielsweise

Sind die Zufallsvariablen paarweise unkorreliert, das heißt ihre Kovarianzen sind alle gleich Null, dann folgt:

Dieser Satz wird auch als Gleichung von Bienaymé bezeichnet. Er gilt insbesondere dann, wenn die Zufallsvariablen unabhängig sind, denn aus Unabhängigkeit folgt Unkorreliertheit.

Charakteristische Funktion

Die Varianz einer Zufallsvariablen

lässt sich auch mit Hilfe ihrer charakteristischen

Funktion

darstellen. Wegen

und

folgt nämlich mit dem Verschiebungssatz

Momenterzeugende Funktion

Da für die momenterzeugenden

Funktion

der Zusammenhang

gilt, lässt sich die Varianz damit auf folgende Weise berechnen:

Wahrscheinlichkeitserzeugende Funktion

Auch mit der wahrscheinlichkeitserzeugenden

Funktion

lässt sich für diskrete

die Varianz berechnen. Es gilt dann

,

falls der linksseitige Grenzwert existiert.

Kumulantenerzeugende Funktion

Die kumulantenerzeugende Funktion einer Zufallsvariable ist definiert als

.

Leitet man sie zweimal ab und wertet sie an der Stelle 0 aus, so erhält man die Varianz:

.

Die zweite Kumulante ist also die Varianz.

Varianz einer zusammengesetzten Zufallsvariable

Ist

eine zusammengesetzte Zufallsvariable, sprich sind

unabhängige Zufallsvariablen und sind die

identisch verteilt und ist

auf

definiert, so lässt sich

darstellen als

.

Existieren die zweiten Momente von ,

so gilt

.

Diese Aussage ist auch als Blackwell-Girshick-Gleichung bekannt.

Beziehung zur Kovarianz

Die Kovarianz

steht mit der Varianz in folgender Beziehung:

.

Die folgt direkt aus den Definitionen. Des Weiteren gilt die Cauchy-Schwarzsche Ungleichung

,

da die Kovarianz eine positiv semidefinite Bilinearform ist.

Beispiele

Diskrete Zufallsvariable

Gegeben ist eine diskrete Zufallsvariable ,

welche die Werte

,

und

mit je den Wahrscheinlichkeiten

,

und

annimmt. Der Erwartungswert beträgt

und die Varianz ist demnach

Mit dem Verschiebungssatz erhält man ebenfalls

Für die Standardabweichung ergibt sich damit

Stetige Zufallsvariable

Eine stetige Zufallsvariable habe die Dichtefunktion

.

Mit dem Erwartungswert von

und dem Erwartungswert von

berechnet sich die Varianz mit Hilfe des Verschiebungssatzes als

Verwandte Begriffe

Fasst man die Varianz als Streumaß der Verteilung einer Zufallsvariable auf, so ist sie mit den folgenden Streumaßen verwandt:

- Der Variationskoeffizient ist eine normierte Variante der Varianz und damit ein dimensionsloses Streuungsmaß.

- Der Quantilabstand

zum Parameter

gibt an, wie weit das

- und das

-Quantil voneinander entfernt sind.

- Die mittlere absolute Abweichung als erstes zentriertes Moment.

In der Statistik gibt es noch weitere empirische Streumaße, die sich aber nicht alle sinnvoll für Verteilungen definieren lassen.

Verallgemeinerungen

Im Falle eines reellen Zufallsvektors

mit quadratisch integrierbaren Komponenten verallgemeinert sich die Varianz zu

der Kovarianzmatrix

eines Zufallsvektors:

Dabei ist

der Vektor der Erwartungswerte. Der Eintrag der

-ten

Zeile und

-ten

Spalte der Kovarianzmatrix ist

.

In der Diagonale stehen also die Varianzen

der einzelnen Komponenten.

Analog zu bedingten Erwartungswerten lassen sich beim Vorliegen von Zusatzinformationen, wie beispielsweise den Werten einer weiteren Zufallsvariablen, bedingte Varianzen betrachten.

© biancahoegel.de

Datum der letzten Änderung: Jena, den: 28.11. 2019