Residuum (Statistik)

In der Statistik bezeichnet man geschätzte Störgrößen als Residuen. Die Problematik bei der Regressionsdiagnostik ist, dass sich die Gauß-Markov-Annahmen auf die Störgrößen und nicht auf die Residuen beziehen. Die Summe der quadrierten Residuen spielt bei der Methode der kleinsten Quadrate eine große Rolle.

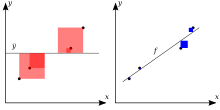

Gewöhnliche Residuen

In der einfachen linearen Regression sind die gewöhnlichen Residuen gegeben durch

.

Hierbei handelt es sich um Residuen, da vom wahren

Wert ein geschätzter Wert abgezogen wird. Genauer gesagt wird von der wahren

Gerade

die geschätzte Gerade

abgezogen. Da die Störgröße

offensichtlich vom einem wahren Wert

als auch von einem geschätzten Wert

abhängt, wird ihr der "Hut aufgesetzt" und sie wird somit zum Residuum. Man

unterscheidet somit wie folgt:

: Unbeobachtbare zufällige Fehler bzw. Störgrößen, deren Existenz man annimmt

: Geschätzte Störgrößen bzw. Residuen

Da die Residuen im Gegensatz zu den Störgrößen beobachtbar und berechnete

Größen sind, können sie graphisch dargestellt oder auf andere Weise untersucht

werden. Im Gegensatz zur einfachen linearen Regression, bei der eine Gerade

bestimmt wird, bestimmt man bei der multiplen linearen Regression (Erweiterung

der einfachen linearen Regression auf

Regressoren) eine Hyperebene,

die durch die Punktwolke verläuft. Falls zwei Regressoren vorliegen, liegen die

Beobachtungen bildlich gesprochen über beziehungsweise unter der

Regressionsebene. Die Differenzen der beobachteten und der prognostizierten, auf

der Hyperebene liegenden y-Werte, stellen die Residuen dar.

Für sie gilt:

.

Die gewöhnlichen Residuen, die durch die Kleinste-Quadrate-Schätzung gewonnen werden sind, wenn zusätzlich n Beobachtungen vorliegen, in der multiplen linearen Regression gegeben durch

,

wobei

eine Projektionmatrix

oder genauer gesagt die symmetrische und idempotente Residualmatrix

darstellt und

den KQ-Schätzer

im multiplen Fall darstellt.

Eigenschaften

Die gewöhnlichen Residuen ergeben im Mittel 0, d. h.

.

Die Kovarianzmatrix der gewöhnlichen Residuen ist gegeben durch

.

Die gewöhnlichen Residuen sind heteroskedastisch, da

.

Dies impliziert, dass für die gewöhnlichen Residuen die Gauß-Markov-Annahmen nicht erfüllt sind.

Mithilfe einer Projektionsmatrix lässt sich zeigen, dass die Residuen mit den prognostizierten Werten unkorreliert sind

.

Residualvarianz

Die Varianz der Residuen (auch Resdualvarianz genannt) ist in der einfachen lineare Regression gegeben durch

.

Partielle Residuen

Partielle Residuen-Streudiagramme werden mithilfe von partiellen Residuen erstellt, die definiert sind durch

.

Studentisierte Residuen

Für dieses einfache Modell sei die Design-Matrix

und die Prädiktionsmatrix

ist die Matrix der Orthogonalprojektion

auf den Spaltenraum der Designmatrix.

ist gegeben durch

.

Die statistischen Hebelwerte

sind die

-ten

Diagonalelemente der Prädiktionsmatrix. Die Varianz des

-ten

Residuums ist gegeben durch

.

In diesem Fall hat die Designmatrix

nur zwei Spalten, was zu folgender Varianz führt

.

Die dazugehörigen studentisierten Residuen sind dann

.

Die studentisierten Residuen sind identisch (aber nicht unabhängig) verteilt und damit insbesondere homoskedastisch. Sie könnten somit eine Lösung für die Verletzung der Homoskedastizitätsannahme darstellen.

© biancahoegel.de

Datum der letzten Änderung: Jena, den: 06.01. 2017